こんにちは、エンジニアの村本です。

AI技術の社会実装が進む中で、「なぜその判断をしたのか」を説明できないブラックボックス問題が課題となっています。本記事では、次に紹介する論文を元に、 説明可能AI(XAI) の最新研究動向を解説します。

紹介する論文: Explainable AI – the Latest Advancements and New Trends

目次

1. 説明可能AIが注目される背景

Trustworthy AIへの関心の高まり

2019年以降、AIの堅牢性・解釈可能性・プライバシー保護に関する研究が活発化しています。AIの産業応用が進むにつれ、人間中心の要素を取り入れた技術が増加し、倫理的・透明性・安全性への懸念が浮上しています。

技術的背景:

2019年前後は、深層学習技術の産業応用が本格化した時期と重なります。特に、BERT(2018年)やGPT-2(2019年)などの大規模言語モデルの登場により、AIの性能は飛躍的に向上しましたが、同時にモデルの複雑性も急激に増大しました。これらの高性能なAIモデルは、従来の機械学習手法と比べて桁違いのパラメータ数を持ち、その判断プロセスの理解が困難になったことが、説明可能性への関心を高める大きな要因となりました。

社会的背景:

同時期に、AIによる差別的判断や誤った意思決定が社会問題として顕在化しました。2018年のAmazonの採用AIにおける性別バイアス問題や、顔認識技術の人種差別問題など、AIの判断が社会に与える影響の深刻さが広く認識されるようになりました。これらの事例は、高性能なAIであっても、その判断根拠が不明確では社会実装において大きなリスクとなることを示しています。

IEEEなどの標準化団体が、倫理認証プログラム(ECPAIS)などの枠組みを導入し、特にAIの解釈可能性が課題となっています。

DARPAのXAIプログラム

米国のDARPAがExplainable AI(XAI)プログラムを開始し、人間が理解しやすいAIの開発を推進しています。

従来の解釈可能AIの限界

従来の 解釈可能AI(Interpretable AI) には以下の課題がありました:

- 性能との両立困難:解釈しやすいモデルは精度が低下する傾向

- コスト増大:説明のためにモデルを簡略化する必要

- 複雑な問題への対応限界:実際のビジネス課題には不十分

説明可能AI(XAI) は、高性能なモデルに後付けで説明機能を追加するアプローチにより、これらの課題解決を目指しています。

2. 各国の規制動向と倫理的枠組み

EU主導の信頼性基準

参考:European Commission: Ethics guidelines for trustworthy AI (2019)

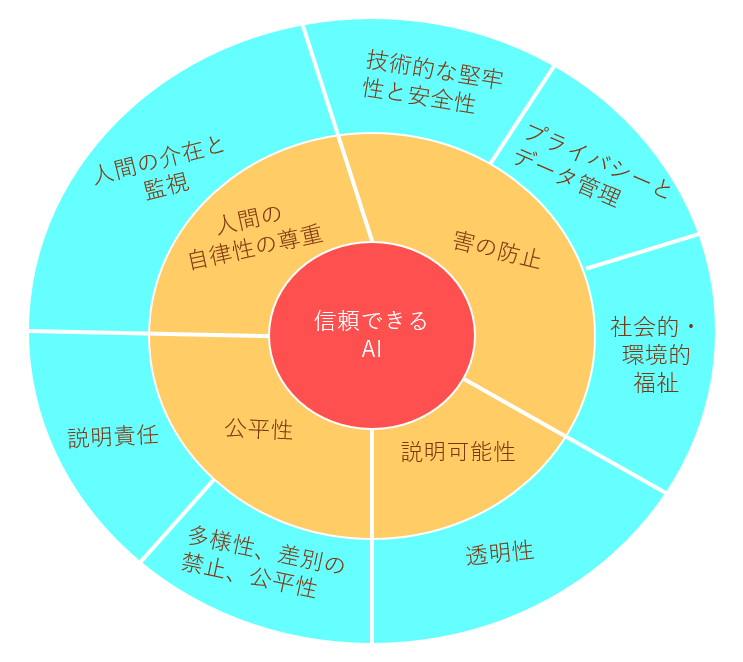

EU AI高水準専門家グループ(AI HLEG)による信頼できるAIの枠組みは、以下の3つの構成要素から成り立っています:

- コア要素 :人間性、情報、物理的側面

- 倫理原則 :自由、プライバシー、尊厳の保護

- 具体的要件 :説明責任、公平性、安全性

図1: AI倫理の4つの基本原則と7つの具体的要件

各国のアプローチ比較

各国のAI倫理ガイドラインの特徴:

米国(NIST AI Risk Management Framework):

- 説明責任と公平性を重視

- 実用主義的アプローチ

- イノベーション促進を優先

EU(AI Act):

- 人間の監督と技術の堅牢性を重視

- 慎重なリスク管理アプローチ

- 透明性要件の厳格化

日本(AI利活用ガイドライン):

- 人間性への貢献を重視

- バランス型アプローチ

- 社会受容性を考慮

これらの違いは、各国の文化的背景や産業構造を反映しており、今後のAI開発戦略にも影響を与えることが予想されます。

3. 技術的アプローチの最新研究

説明可能AI(XAI)を実現するための技術的アプローチについて紹介します。

範囲ベース解釈手法

従来のLIMEやSHAPといった点推定による説明手法に対し、範囲ベースアプローチは以下の優位性を持ちます:

従来手法の限界:

- 個別の入力に対する局所的説明のみ

- 全体的な傾向の把握が困難

- モデルの安定性評価が限定的

新アプローチの利点:

- 入力値の範囲全体での挙動を分析

- モデルの安定性や信頼性を評価可能

- リスク分析や異常検知にも応用可能

実用例:

融資判定において、「年収400-600万円の範囲では勤続年数が最も重要な判断要素になる」といった包括的な説明が可能になります。

シーケンスベース解釈手法

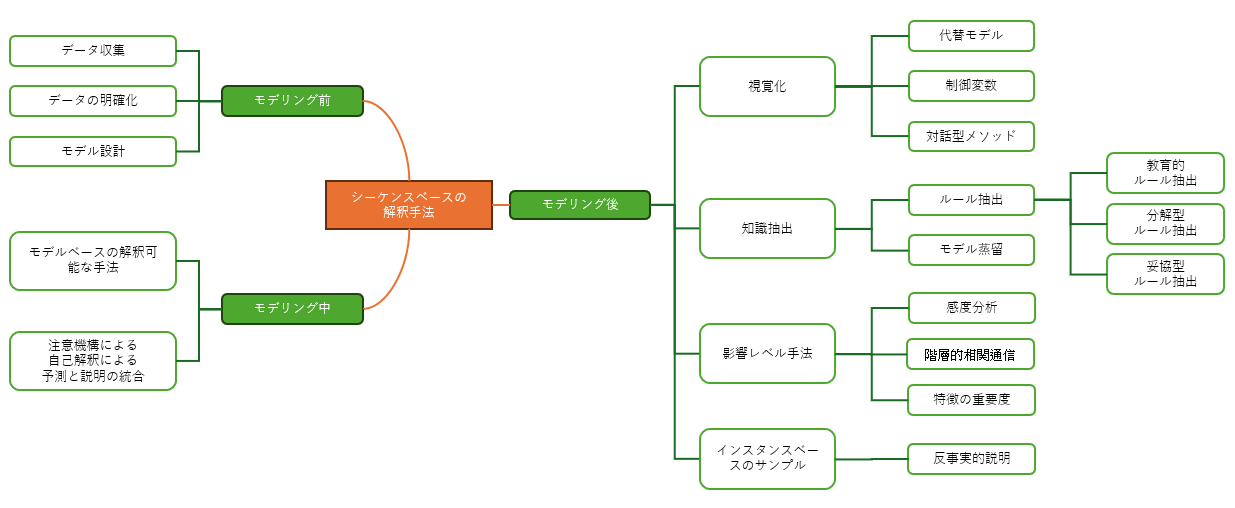

図2: シーケンスベースの解釈手法の流れ

シーケンスベースアプローチは、AIの判断を段階的な思考プロセスとして説明する手法です:

主な特徴:

- 人間の思考様式に近い逐次的な説明

- 中間的な推論プロセスの明示

- 検証・再現が容易

技術的基盤:

- 注意機構(Attention Mechanisms)の活用

- 段階的推論プロセスの可視化

- 因果関係の明示

実用例: 医療診断AIが「症状確認 → 検査データ分析 → 診断結果」という流れで、各段階の判断根拠を説明します。

4. 実用化への取り組みと課題

メタ推論との融合

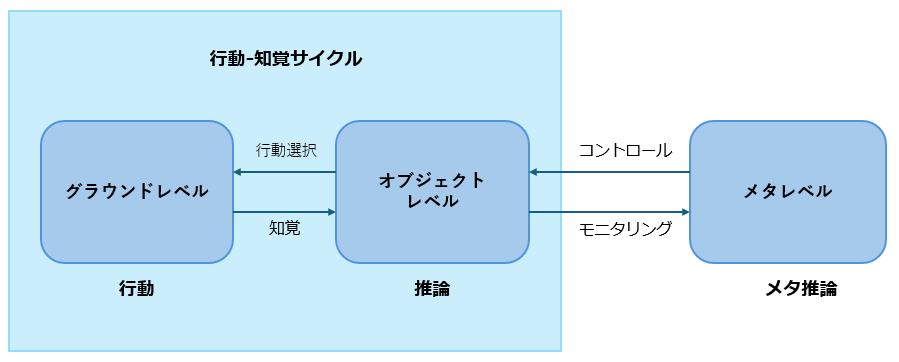

メタ推論の概要:

- AIが自らの思考プロセスを振り返る能力

- 判断根拠を自己説明する仕組み

- 説明可能AIの発展形態

図3: メタ推論における推論と行動の二重性

図3: メタ推論における推論と行動の二重性

技術的アプローチ:

- 自己監視機構の実装

- 推論プロセスの内省的分析

- 説明生成の自動化

この技術により、AIは外部ツールに依存せず、自分の判断を説明できるようになる可能性があります。

信頼できる自律型システムとドメインランダマイゼーション技術

ドメインランダマイゼーション技術:

- シミュレーション環境での多様な学習

- 現実世界への汎化能力向上

- 説明可能性の維持

自動運転での応用例:

- 従来:急ブレーキの理由が不明

- 新技術:「歩行者検知 → 衝突リスク計算 → 緊急回避」の説明

LLMとの統合研究

LLM(Large Language Model:大規模言語モデル)は、膨大なテキストデータを学習し、人間のように自然な文章を生成・理解できるAIモデルです。 現在のLLMブームは、XAIにとって重要な技術基盤となっています:

LLMの利点:

- LLMは、自然言語による説明生成能力を持つため、XAIの目的である「人間に理解可能な説明」の提供に適している

- 特に、ユーザーとの対話型インターフェースとして機能することで、AIの判断根拠を自然な言葉で伝えることが可能

最新研究動向:

- プロンプトエンジニアリングによる説明生成

- ファインチューニングを通じた説明品質向上

- マルチモーダル説明の実現

課題:

- LLMによる説明は、事実性や一貫性の保証が難しいという課題

- 説明が「もっともらしく」ても、誤情報や曖昧な表現が含まれる可能性があるため、検証可能性の確保が重要

5. ビジネス活用の展望

短期的な活用領域(1-2年)

人事・採用分野:

- 採用AIの判断根拠の透明化

- 公平性の確保と説明責任の向上

- 法的リスクの軽減

金融サービス:

- 融資審査プロセスの改善

- 規制要件(Basel III、GDPR)への対応強化

- 顧客満足度向上

マーケティング:

- レコメンドシステムの根拠説明

- 顧客への価値提供の向上

- A/Bテストの効果測定

中長期的な発展(3-5年)

医療・ヘルスケア:

- 診断支援システムの信頼性向上

- 医療従事者との協働強化

- 患者への説明責任向上

製造業:

- 品質管理システムの透明性向上

- 予防保全の根拠説明

- 製造プロセスの最適化

公共サービス:

- 政策決定プロセスへの活用

- 市民への説明責任の向上

- 公平性の確保

実装における課題

実際のビジネス導入では、以下の課題への対応が必要です:

技術的課題:

- 計算コストの最適化

- リアルタイム説明生成の実現

- 説明品質の客観的評価

組織的課題:

- 従業員の理解促進

- 既存システムとの統合

- 法的責任の明確化

文化的課題:

- 地域や業界に応じた説明方法の調整

- ユーザー受容性の確保

- 説明の「適切さ」の定義

6. まとめ

説明可能AIの発展により、AI技術の透明性と信頼性が大幅に向上することが期待されます。特に、規制要件への対応や顧客への説明責任が重要な業界では、早期の導入検討が推奨されます。

技術的には、範囲ベースやシーケンスベースといった新しいアプローチが実用化に向けて進展しており、メタ推論やLLMとの統合により、さらなる発展が見込まれます。

ビジネス導入にあたっては、技術的な課題だけでなく、組織文化や法的要件への対応も重要な要素となります。段階的な導入と継続的な改善により、説明可能AIの効果を最大化できると考えられます。

7. おわりに

説明可能AI(XAI)のトレンドを包括的にまとめたレビュー論文でした。

倫理的枠組み、技術的手法、実世界での応用、そしてメタ推論との統合までを幅広くカバーし、今後の研究課題や展望についても考察しています。

弊社ではAIを積極活用しながらも、AI技術の進歩とともに変化する課題やリスクを認識し、常に最新の知見を取り入れながら、お客様が安心してご利用いただける信頼性の確保やリスク管理に対応したシステム開発を行っています。

また、AI導入やツール選定に関するご相談も承っておりますので、ぜひお気軽にお問い合わせください。

主な参考文献:

- European Commission: Ethics guidelines for trustworthy AI (2019)

- Global Model Interpretation via Recursive Partitioning).

- Explainable Artificial Intelligence (XAI): Concepts, taxonomies, opportunities and challenges toward responsible AI

- The UKRI Trustworthy Autonomous Systems (TAS) Hub

- A Comprehensive Study on Robustness of Image Classification Models: Benchmarking and Rethinking (2024)

- Large Language Models as Analogical Reasoners (2023)

- Meta Reasoning for Large Language Models

詳細な技術仕様や最新の研究動向については、原文をご参照ください。この分野は急速に発展しており、定期的な情報収集が重要です。