はじめに

近年、AIの発展は目覚ましく、2025年初頭の現在では一般のPCでもChatGPTのようなAIが動く状況になりつつあります。 周辺技術も徐々に複雑化しており、プログラム自動開発のCline、ノードベース画像生成UIのComfyなど、次世代のスタンダードとして有力なアプリケーションが出てきています。

この記事では、話題になっているDeepSeekの日本語版をローカルPCで動かすための背景知識やツールを紹介し、具体的に導入する手順をご紹介します。

目次

最近のAI環境

ここ数年AI関連の競争が激しい状況が続いていますが、特に2024年末~2025年初頭の現在、さらにその傾向が強くなっています。

以下は2024年末~2025年の話題をまとめたものです。

| 発表日 | 企業 | モデル名 | 主な特徴・内容 |

|---|---|---|---|

| 2024/12/17 | OpenAI | o1 | 専門的な内容に強いモデル リンク |

| 2024/12/26 | DeepSeek | V3 | オープンソース、OpenAI互換APIを特徴とする安価なモデル リンク |

| 2025/01/20 | DeepSeek | R1 | OpenAI o1級の性能とされるオープンソースモデル リンク |

| 2025/01/23 | OpenAI | Operator | ブラウザ操作が可能なエージェント リンク |

| 2025/01/31 | OpenAI | o3-mini | 小規模ながら高性能な推論を可能とするモデル リンク |

| 2025/02/02 | OpenAI | Deep Research | アナリスト等の利用を想定した情報収集、資料化ツール リンク |

特に中国の企業DeepSeekのオープンソースモデル発表は米国精密機械産業の株価やAI関連企業にも影響を与えており、より一層競争が激しくなることが予想されます。

私もSNSで動向を追っていますが、ここ最近の流行の変化はこれまで以上に激しさを増してます。人によってはどこから見ればいいのか迷ってしまうのではないでしょうか?

そこで、今回の記事では特に大きいムーブメントを引き起こしたDeepSeekのオープンソースモデルに絞って、自身のローカル環境で実行する方法をご紹介しようと思います。

前提

AIをローカル環境で動作させるためにはGPUが必須です。 プログラムの構造上、CPUや中程度以下のスペックをもつGPUで実行することも不可能ではありませんが、失敗しているのか、単純に時間がかかっているのかがわからないほどの時間がかかるためおすすめはできません。

参考に筆者のPCスペックを書きます。参考にしてください。

| 項目 | スペック |

|---|---|

| CPU | Intel Core i7-8700K (3.70GHz, 12コア) |

| RAM | 64GB |

| GPU | NVIDIA GeForce RTX 4070 Ti SUPER |

| VRAM | 16GB |

| OS | Windows 11 Pro 64ビット (ビルド26100) |

使うツール・サイト

今回使うWebサイトやツールを紹介します。

Hugging Face:AIモデルの共有プラットフォーム

AI関連のモデルファイルの共有プラットフォームとして多用されるWebサービス。 AIモデルのバージョン毎のダウンロード、同じアップロード元のモデル確認、ライセンスへの同意に基づくダウンロード、Web上でのモデルの実行などAI関連の共有に役立つ機能を提供しています。

今回は、AIモデルのダウンロード元としてこのWebサービスを使用します。

Ollama:AIモデルの実行用プログラム

LLM(Large Language Model)、つまり大規模言語モデルを動かすためのプログラムです。このツールを使わなくても大規模言語モデルは実験できますが、数行とはいえPythonコードを書く必要があります。Ollamaを使用すると統一されたコマンドでモデルのダウンロードから実行まで行うことができ、本質的でない作業をスキップできます。

今回は、モデルのダウンロード、実行をこのプログラムで行います。

OpenWeb UI:ブラウザからメッセージを入力できるようにするUIツール

OpenWeb UIは、pythonのパッケージとして提供されるツールです。これをインストールすることで、Ollama上で実行されるLLMとのチャットを、OpenAIやAnthropicのWebサービスのようなUIで試すことができます。

今回は、最終的なUIとしてこのツールを経由してLLMを使用します。

試してみよう

それでは実際に試してみましょう。失敗なくインストールが進めば、10分程度で試せるかと思います。

Ollamaのインストール

まず、Ollamaをインストールします。以下のURLから環境に合わせたOllamaをダウンロードしてください。

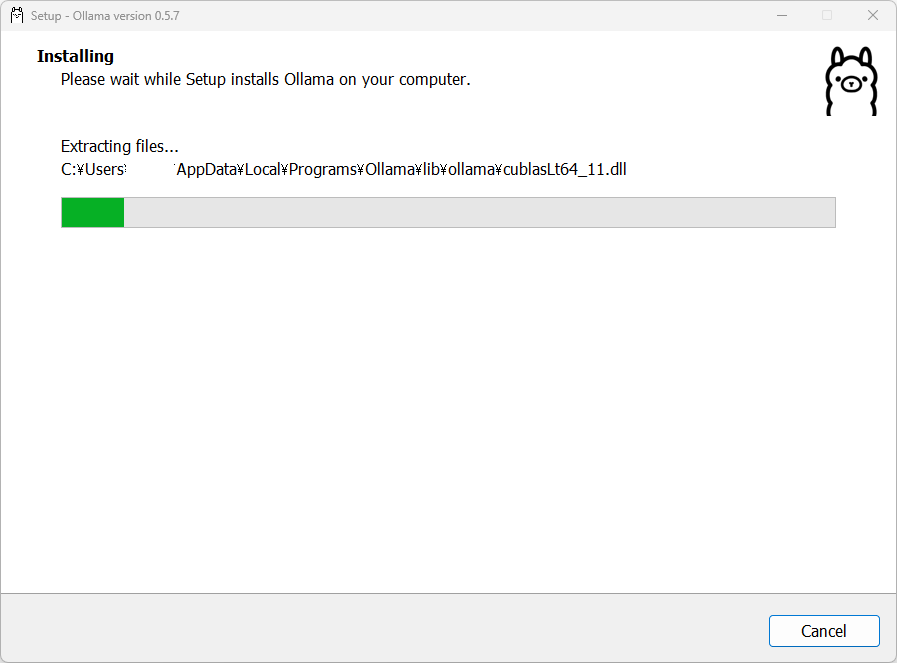

インストール中は以下のようになります。

★重要 インストール後に実行しても、ウインドウなどは開きません。 タスクバーの右端に、小さいラマのマークが表示されていれば準備完了です。

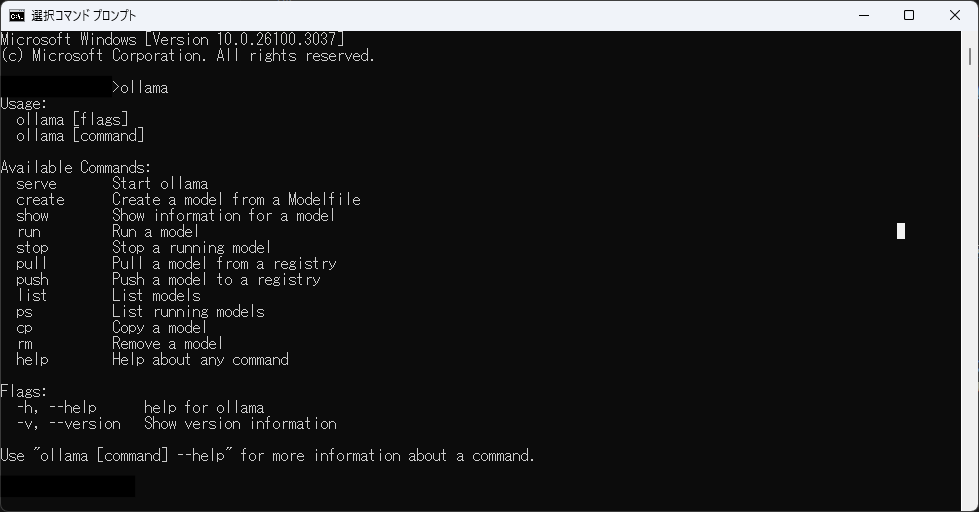

試しに Windowsキー → コマンドプロンプト と入力して、コマンドプロンプトを起動します。 コマンドプロンプトが開いたら、「ollama」と入力してエンターキーを押します。

画像のように、ollamaのヘルプが表示されれば無事ollamaが動作しています。 次のステップでもコマンドプロンプトを使うため、コマンドプロンプトは開いたままにしておきます。

LLMモデルダウンロードコマンドの取得

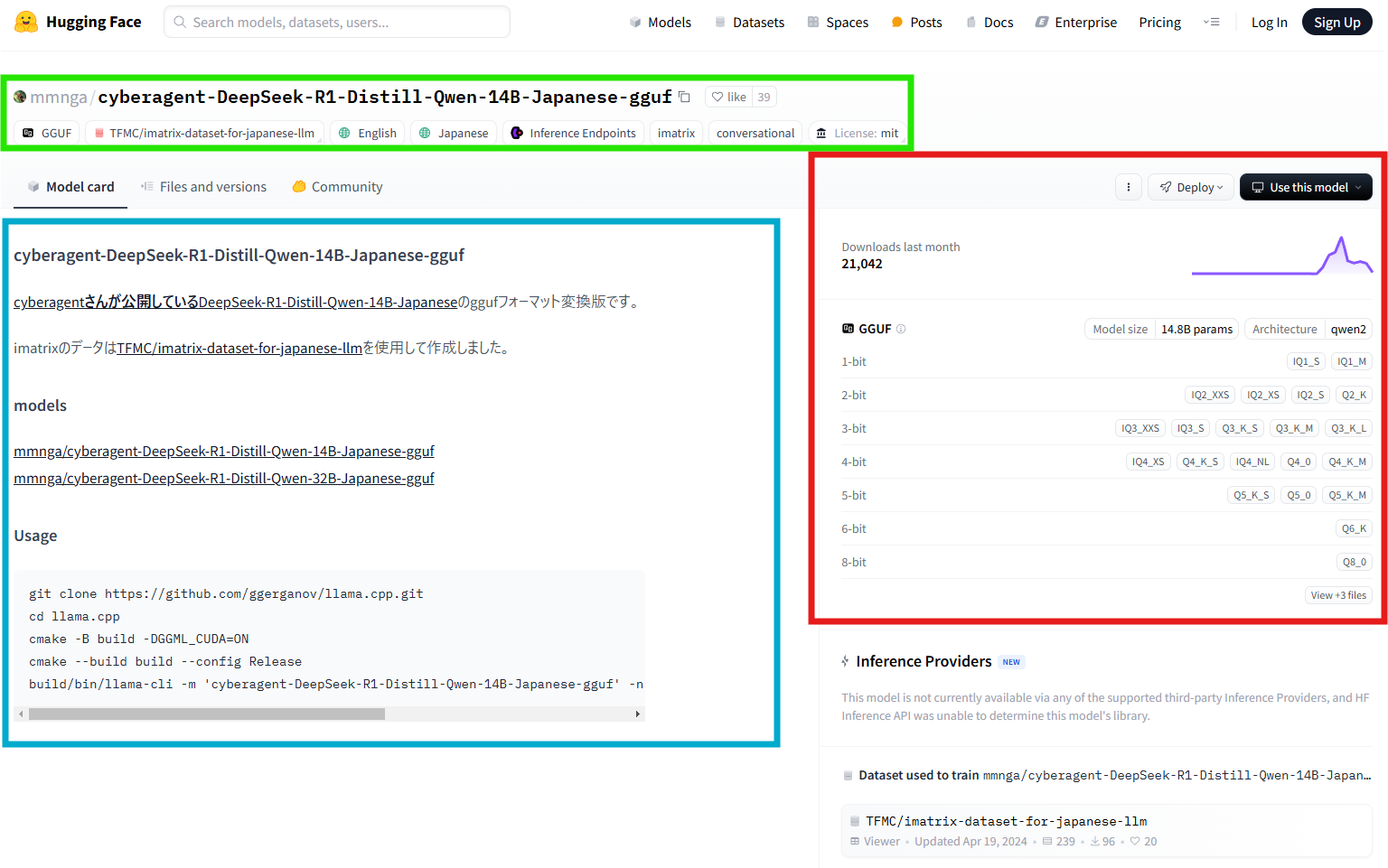

次は、Hugging Faceから動作させるLLMモデルをダウンロードします。以下のページにアクセスしてください。

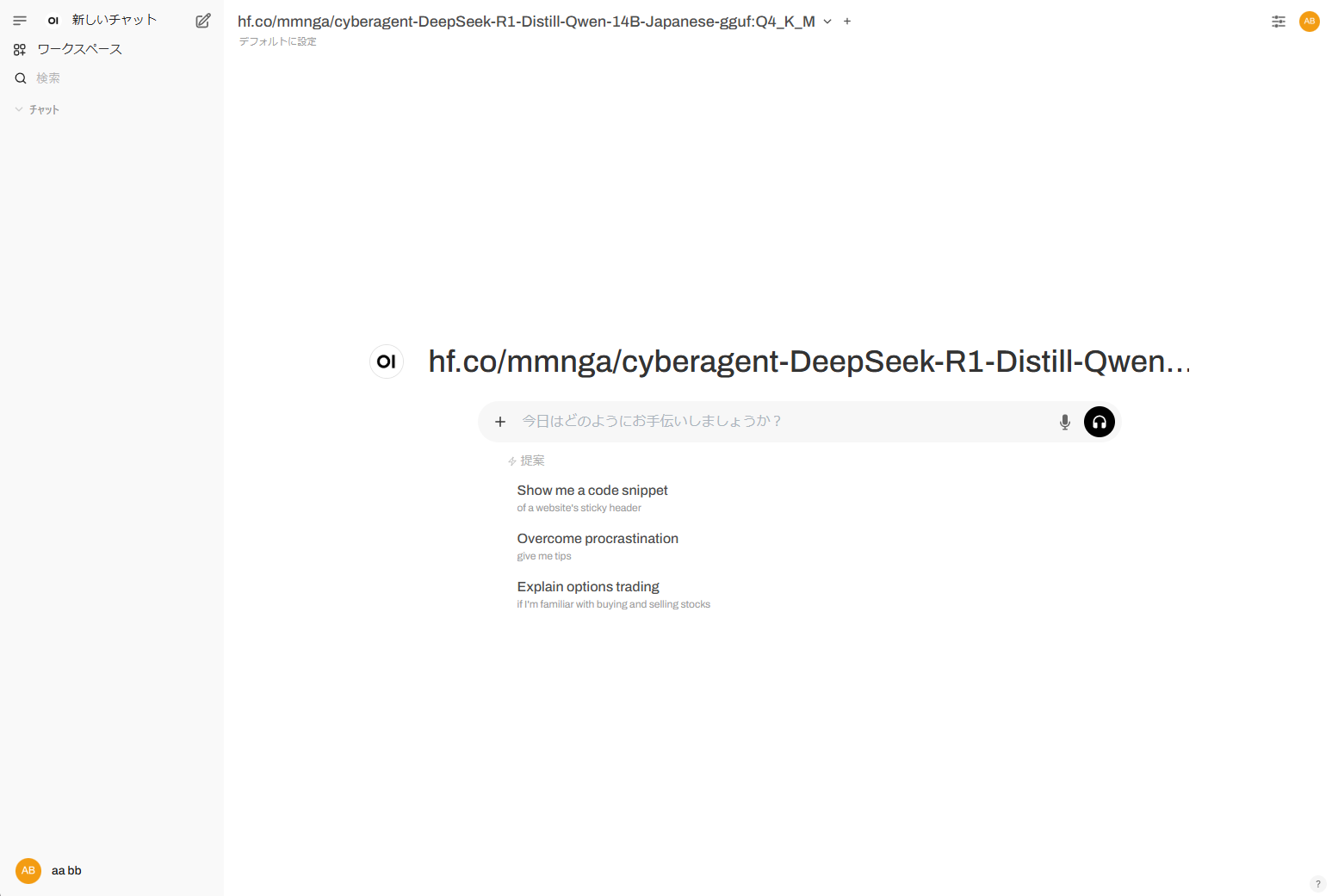

https://huggingface.co/mmnga/cyberagent-DeepSeek-R1-Distill-Qwen-14B-Japanese-gguf

Hugging Faceのページが表示されました。少々画面の情報量が多いですが、以下のようなイメージで捉えてください。 - 画像の緑枠=モデル名・関連タグ・属性 - 青枠=README - 赤枠=ダウンロード関連

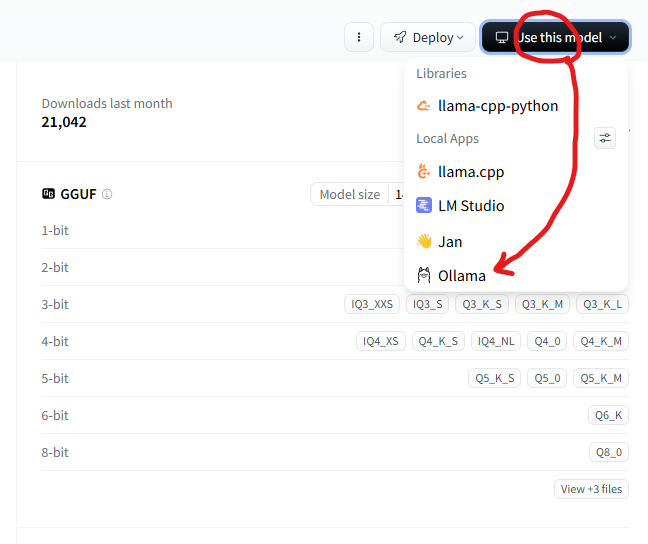

ダウンロード用のコマンドを取得します。画像の赤枠内「Use this model」ボタンをクリックし、「Ollama」をクリックしてください。

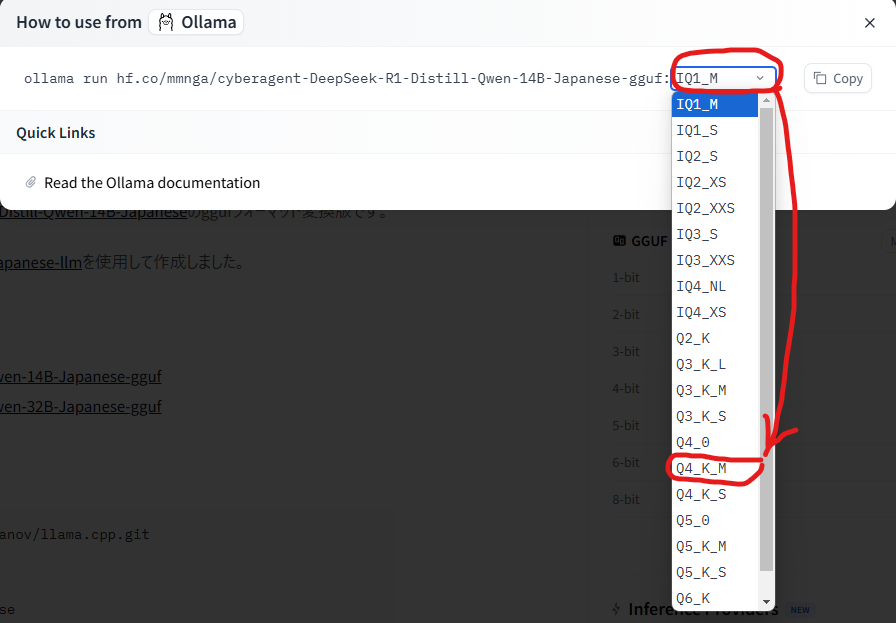

さらに、数字とアルファベットが表示されているドロップダウンをクリックして、ダウンロードする対象を選びます。 今回は、4-bit、K-meansによる処理が行われている「Q4_K_M」を選びましょう。

ドロップダウンから選択出来たら、Copyボタンを押してコマンドをコピーします。

Ollama経由でダウンロード

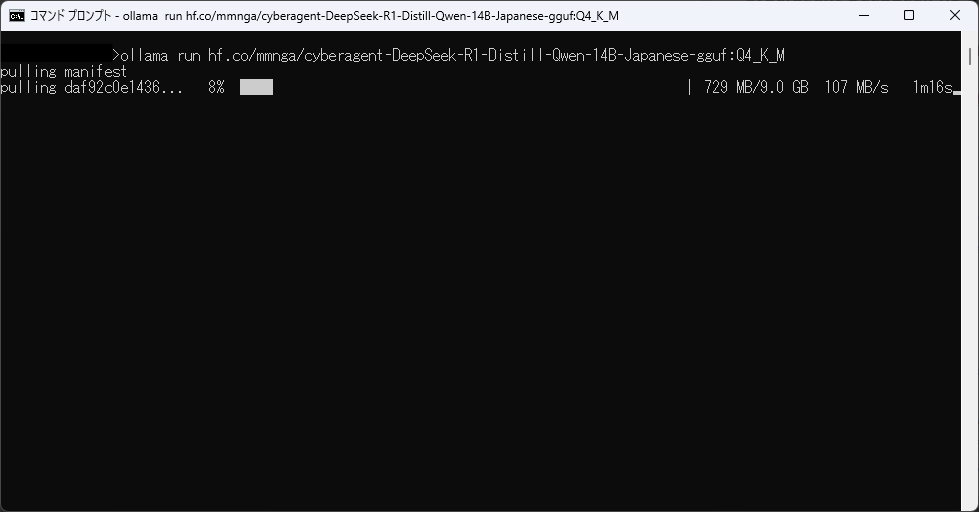

コピーしたコマンドを、先ほど開いたコマンドプロンプトに張り付けてEnterキーを押してください。

以下の画面のようにダウンロードが開始したら成功です。完了まで待ちます。

Note: 今回ダウンロードしたモデルはオリジナルのDeepSeek R1 ではありません。OpenAI o1と同等性能とされるオリジナルのDeepSeek R1は現代のPCではまだ、気軽にローカル環境で動かすことは難しいサイズのモデルです。今回ダウンロードするモデルは、DeepSeek R1の発表から一週間後にCyberAgent社が公開した日本語追加学習モデルを、蒸留と呼ばれる手段で軽量化したモデルです。

【途中確認】Ollama上での実行

ダウンロードが終わったら、いくつかのメッセージが表示された後にメッセージが入力できるようになります。動作確認のため、適当な質問をしてみましょう。

>>> Send a message (/? for help) ←ここに何か書いてEnter

返答が表示されれば、確認はOKです。以下コマンドで会話を終了しましょう。

/bye

OpenWeb UIのインストール

先ほど試していただいた通り、すでにLLMはローカルPC上で動作しています。しかし、メッセージのやり取りがコマンドプロンプト上で行われているため、マークダウンの整形も効きませんし、フォントも見づらいかと思います。 この入出力をリッチなUI経由にして、あたかもOpenAIやAnthropicのサービスを使っているかのようにローカルAIを使う設定を行います。

まずは、python (3.12) コマンドを使える状態にしてください。インストールされているpythonでも、Anacondaにより作成した環境でも構いません。 pythonバージョンは、3.12をお勧めします。執筆時点で最新の3.13ではインストールに失敗しました。

pythonの用意ができたら、以下のコマンドを実行します。依存パッケージが多いため、少し待ちます。

python -m pip install open-webui

インストールが終わったら完了です。

OpenWeb UIの実行

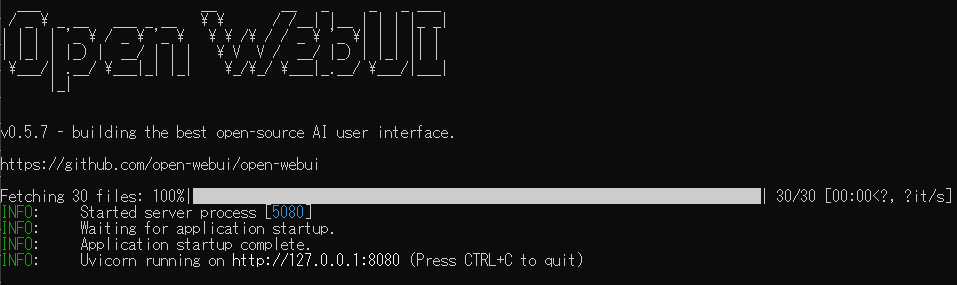

それではOpenWeb UIを実行します。以下のコマンドを入力しエンターキーを押します。

open-webui serve --host 127.0.0.1

以下のような状態になったら準備完了です。

画面に表示されている指示に従い、以下のURLにアクセスしてみましょう。

表示された画面内の「Get Started」をクリックし、入力画面が出てきたら適当な情報を入力します。 Note この情報は外部に接続しているわけではなく、ダミーの情報で問題ありません。私は以下のように入力しました。 - 名前: aa bb - メールアドレス:aaa@bbb.com - パスワード:aaa

以下の画面が表示され、画面上部にダウンロードしたLLMモデルの名前が出ていれば成功です!おめでとうございます!!

【動作確認】OpenWeb UIからチャット

それでは、好きな質問をして動作を試してみましょう。

精度について

最後に、精度について少し補足をしましょう。 少し使っていただくと気づいた方もいたかと思いますが、現時点でローカル実行できるLLMは、性能に限界があります。 過去の、LLMをローカルでインタラクティブに実行するなど夢物語だった時代から比べれば、クラウドの力を借りずコンピュータと対話ができることは驚くべきことです。 しかし、OpenAIやAnthropicが提供するようなサービスは、今回使用したモデルよりもはるかに巨大なモデルを、高速に動作させて実現しています。 これらのサービスと比べるとローカルLLMの品質はまだまだ発展途上で、今後の成長が期待されます。

まとめ

この記事では以下をご紹介しました。 - 直近のAI関連の出来事 - ローカルLLM関連ツール - 各ツール導入方法

弊社では AI x 可視化 をテーマとして積極的な開発に取り組んでいます。 より詳しいAI導入サポートや、御社の開発プロセスに合わせたソリューションの提供・カスタマイズについてもご相談を承っております。是非ご連絡ください!